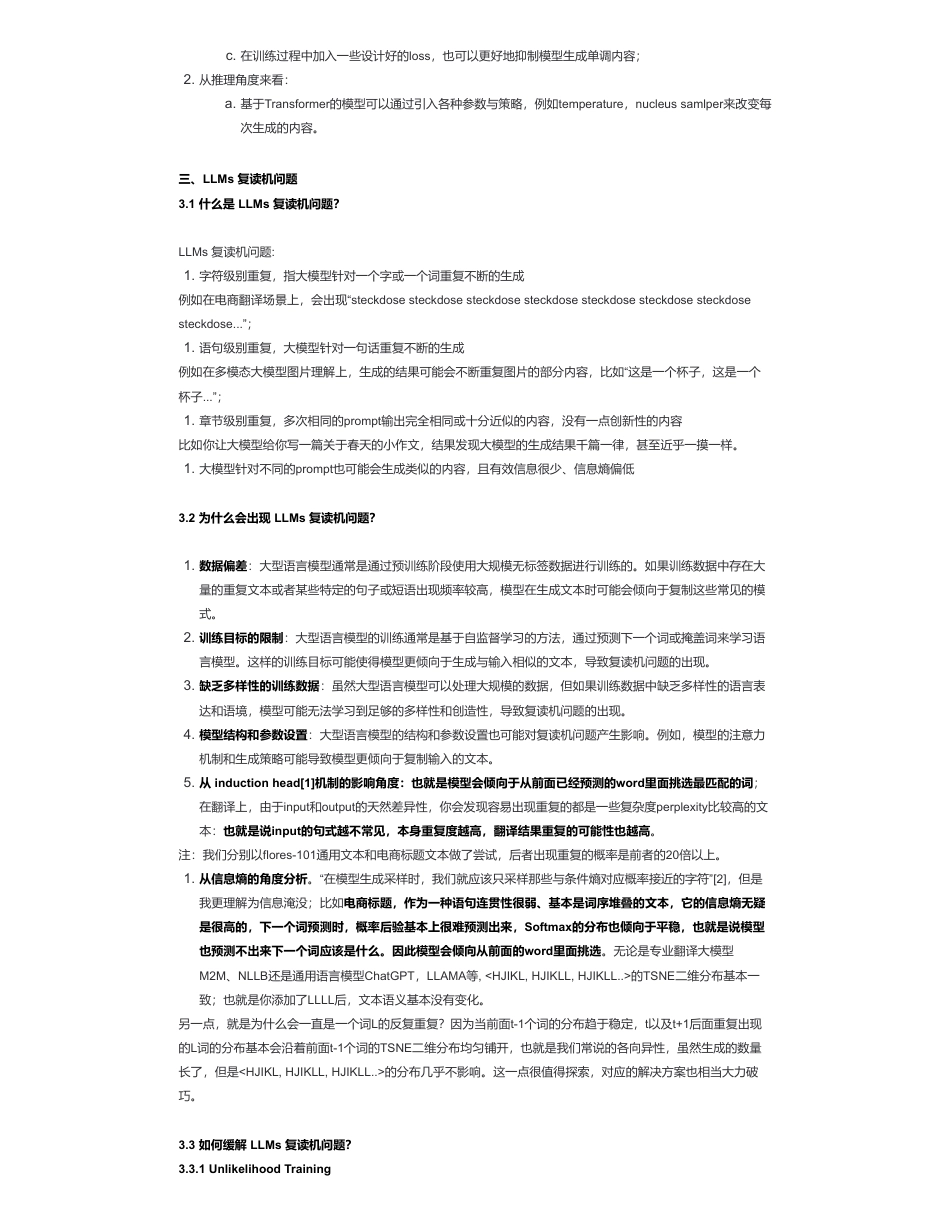

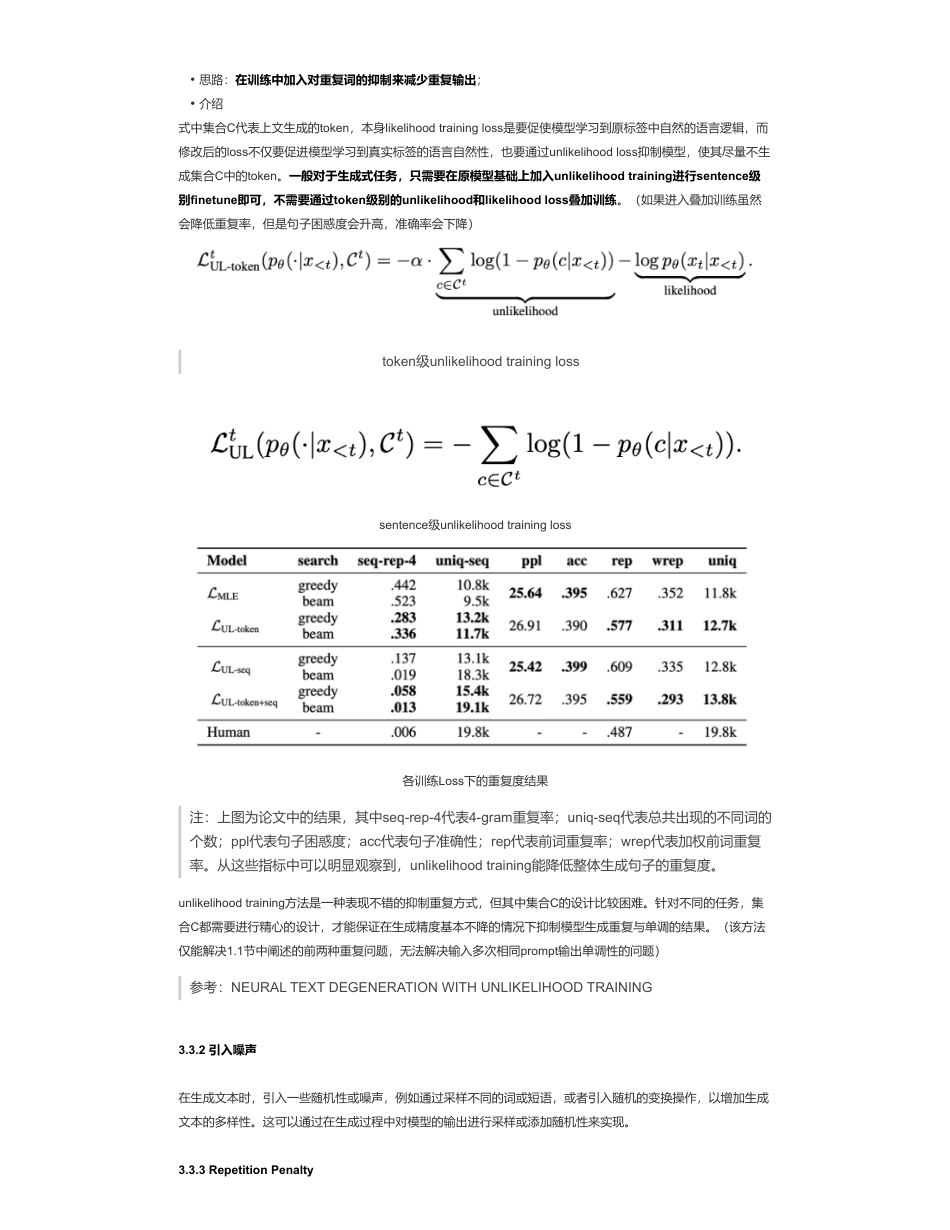

大模型(LLMs)进阶面来自:AiGC面试宝典宁静致远2023年09月28日21:54一、什么是生成式大模型?生成式大模型(一般简称大模型LLMs)是指能用于创作新内容,例如文本、图片、音频以及视频的一类深度学习模型。相比普通深度学习模型,主要有两点不同:二、大模型是怎么让生成的文本丰富而不单调的呢?•大模型(LLMs)进阶面•一、什么是生成式大模型?•二、大模型是怎么让生成的文本丰富而不单调的呢?•三、LLMs复读机问题•3.1什么是LLMs复读机问题?•3.2为什么会出现LLMs复读机问题?•3.3如何缓解LLMs复读机问题?•3.3.1UnlikelihoodTraining•3.3.2引入噪声•3.3.3RepetitionPenalty•3.3.4ContrastiveSearch•3.3.5BeamSearch•3.3.6TopKsampling•3.3.7Nucleussampler•3.3.8Temperature•3.3.9Norepeatngramsize•3.3.10重复率指标检测•3.3.11后处理和过滤•3.3.12人工干预和控制•四、llama系列问题•4.1llama输入句子长度理论上可以无限长吗?•五、什么情况用Bert模型,什么情况用LLaMA、ChatGLM类大模型,咋选?•六、各个专业领域是否需要各自的大模型来服务?•七、如何让大模型处理更长的文本?•致谢1.模型参数量更大,参数量都在Billion级别;2.可通过条件或上下文引导,产生生成式的内容(所谓的promptengineer就是由此而来)。1.从训练角度来看:a.基于Transformer的模型参数量巨大,有助于模型学习到多样化的语言模式与结构;b.各种模型微调技术的出现,例如P-Tuning、Lora,让大模型微调成本更低,也可以让模型在垂直领域有更强的生成能力;扫码加查看更多三、LLMs复读机问题3.1什么是LLMs复读机问题?LLMs复读机问题:例如在电商翻译场景上,会出现“steckdosesteckdosesteckdosesteckdosesteckdosesteckdosesteckdosesteckdose...”;例如在多模态大模型图片理解上,生成的结果可能会不断重复图片的部分内容,比如“这是一个杯子,这是一个杯子...”;比如你让大模型给你写一篇关于春天的小作文,结果发现大模型的生成结果千篇一律,甚至近乎一摸一样。3.2为什么会出现LLMs复读机问题?注:我们分别以flores-101通用文本和电商标题文本做了尝试,后者出现重复的概率是前者的20倍以上。另一点,就是为什么会一直是一个词L的反复重复?因为当前面t-1个词的分布趋于稳定,t以及t+1后面重复出现的L词的分布基本会沿着前面t-1个词的TSNE二维分布均匀铺开,也就是我们常说的各向异性,虽然生成的数量长了,但是的分布几乎不影响。这一点很值得探索,对应的解决方案也相当大力破巧。3.3如何缓解LLMs复读机问题?3.3.1UnlikelihoodTrainingc.在训练过程中加入一些设计好的loss,也可以更好地抑制模型生成单调内容;2.从推理角度来看:a.基于Transformer的模型可以通过引入各种参数与策略,例如temperature,nucleussamlper来改变每次生成的内容。1.字符级别重复,指大模型针对一个字或一个词重复不断的生成1.语句级别重复,大模型针对一句话重复不断的生成1.章节级别重复,多次相同的prompt输出完全相同或十分近似的内容,没有一点创新性的内容1.大模型针对不同的prompt也可能会生成类似的内容,且有效信息很少、信息熵偏低1.数据偏差:大型语言模型通常是通过预训练阶段使用大规模无标签数据进行训练的。如果训练数据中存在大量的重复文本或者某些特定的句子或短语出现频率较高,模型在生成文本时可能会倾向于复制这些常见的模式。2.训练目标的限制:大型语言模型的训练通常是基于自监督学习的方法,通过预测下一个词或掩盖词来学习语言模型。这样的训练目标可能使得模型更倾向于生成与输入相似的文本,导致复读机问题的出现。3.缺乏多样性的训练数据:虽然大型语言模型可以处理大规模的数据,但如果训练数据中缺乏多样性的语言表达和语境,模型可能无法学习到足够的多样性和创造性,导致复读机问题的出现。4.模型结构和参数设置:大型语言模型的结构和参数设置也可能对复读机问题产生影响。例如,模型的注意力机制和生成策略可能导致模型更倾向于复制输入的文本。5.从inductionhead[1]机制的影响角度:也就是模型会倾向于从前面已经预测...

发表评论取消回复