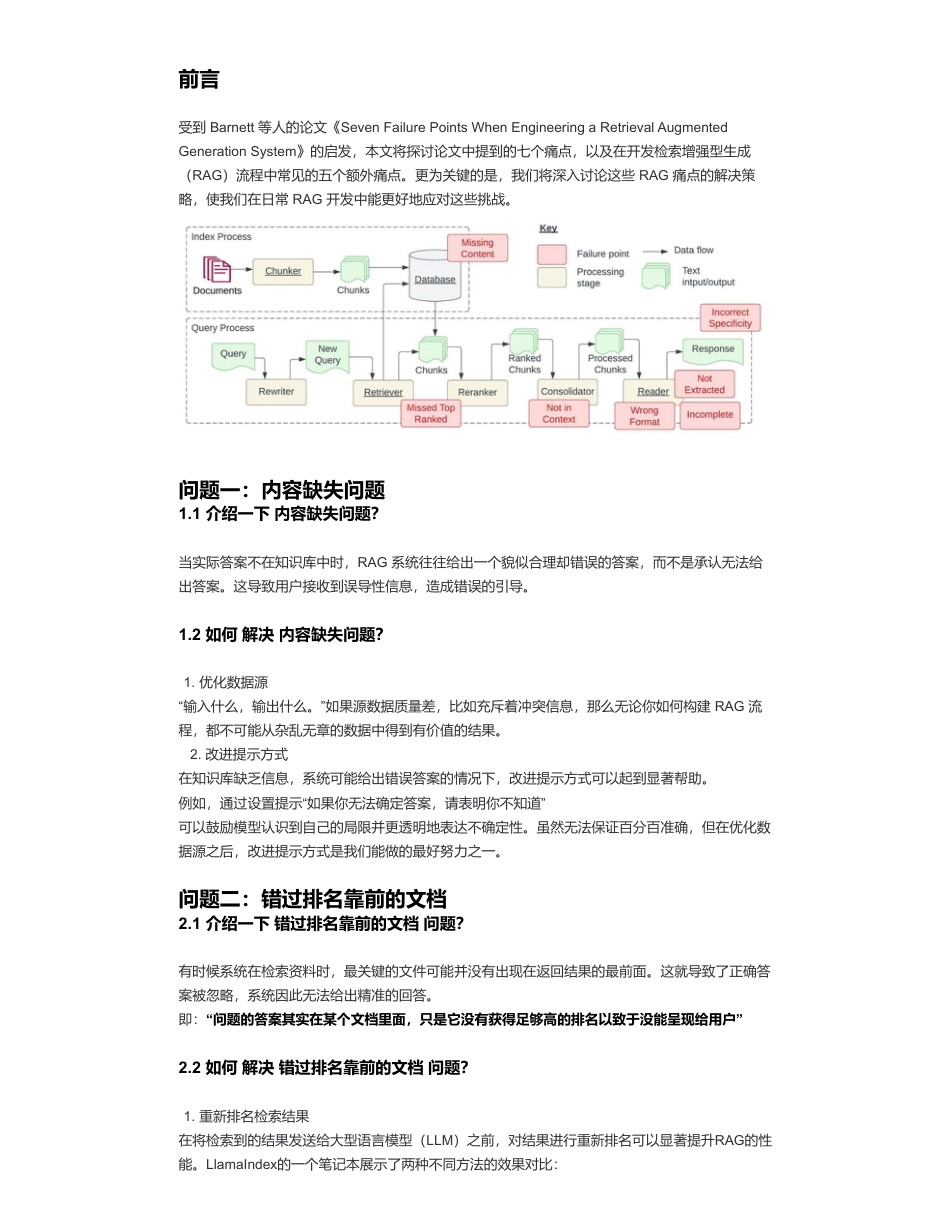

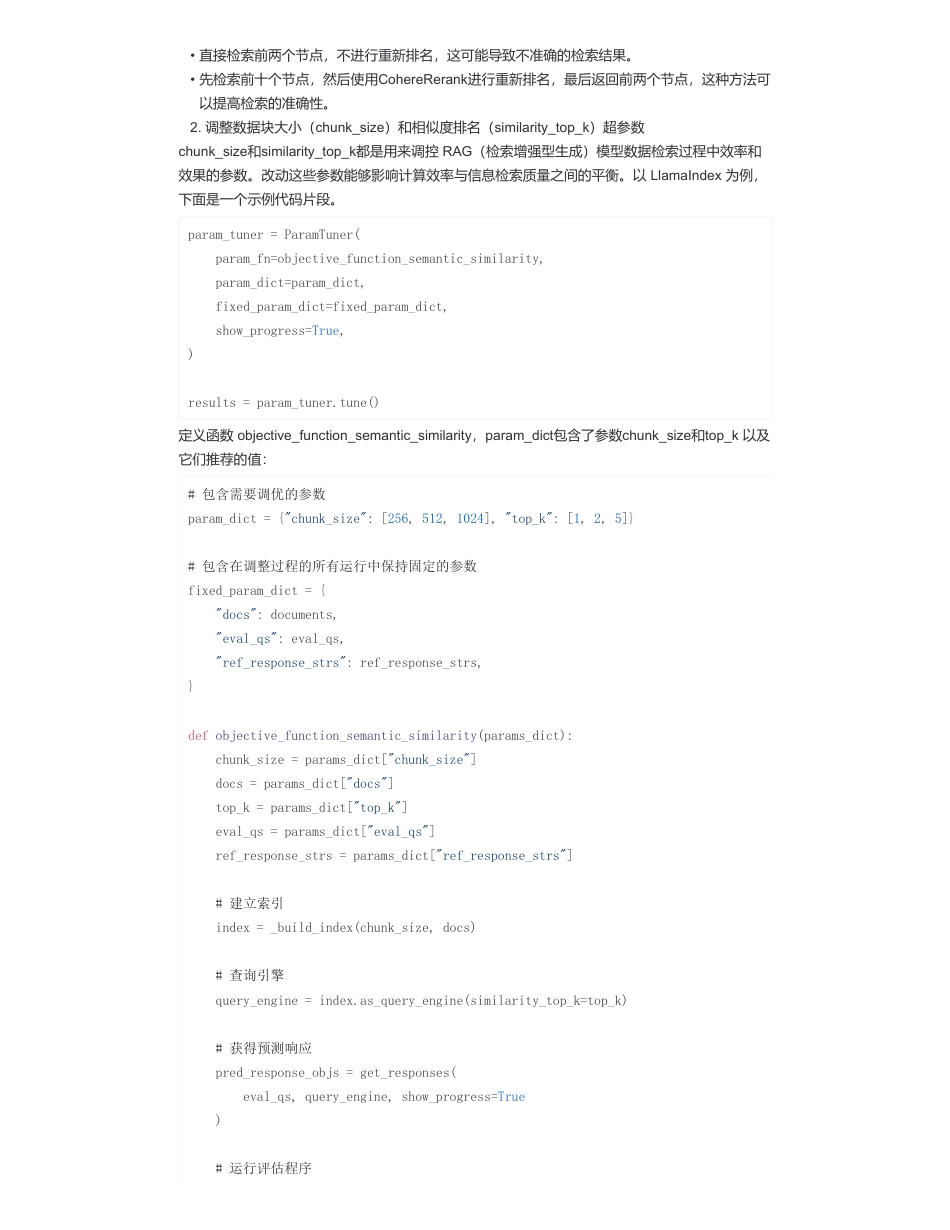

大模型(LLMs)RAG——关键痛点及对应解决方案来自:AiGC面试宝典宁静致远2024年03月19日22:30•大模型(LLMs)RAG——关键痛点及对应解决方案•前言•问题一:内容缺失问题•1.1介绍一下内容缺失问题?•1.2如何解决内容缺失问题?•问题二:错过排名靠前的文档•2.1介绍一下错过排名靠前的文档问题?•2.2如何解决错过排名靠前的文档问题?•问题三:脱离上下文—整合策略的限制•3.1介绍一下脱离上下文—整合策略的限制问题?•3.2如何解决脱离上下文—整合策略的限制问题?•问题四:未能提取答案•4.1介绍一下未能提取答案问题?•4.2如何解决未能提取答案问题?•问题五:格式错误•5.1介绍一下格式错误问题?•5.2如何解决格式错误问题?•问题六:特异性错误•6.1介绍一下特异性错误问题?•6.2如何解决特异性错误问题?•问题七:回答不全面•7.1介绍一下回答不全面问题?•7.2如何解决回答不全面问题?•问题八:数据处理能力的挑战•8.1介绍一下数据处理能力的挑战问题?•8.2如何解决数据处理能力的挑战问题?•问题九:结构化数据查询的难题•9.1介绍一下结构化数据查询的难题问题?•9.2如何解决结构化数据查询的难题问题?•问题十:从复杂PDF文件中提取数据•10.1介绍一下从复杂PDF文件中提取数据问题?•10.2如何解决从复杂PDF文件中提取数据问题?•问题十一:备用模型•11.1介绍一下备用模型问题?•11.2如何解决备用模型问题?•问题十二:大语言模型(LLM)的安全挑战•12.1介绍一下大语言模型(LLM)的安全挑战问题?•12.2如何解决大语言模型(LLM)的安全挑战问题?•总结•致谢扫码加查看更多前言受到Barnett等人的论文《SevenFailurePointsWhenEngineeringaRetrievalAugmentedGenerationSystem》的启发,本文将探讨论文中提到的七个痛点,以及在开发检索增强型生成(RAG)流程中常见的五个额外痛点。更为关键的是,我们将深入讨论这些RAG痛点的解决策略,使我们在日常RAG开发中能更好地应对这些挑战。问题一:内容缺失问题1.1介绍一下内容缺失问题?当实际答案不在知识库中时,RAG系统往往给出一个貌似合理却错误的答案,而不是承认无法给出答案。这导致用户接收到误导性信息,造成错误的引导。1.2如何解决内容缺失问题?“输入什么,输出什么。”如果源数据质量差,比如充斥着冲突信息,那么无论你如何构建RAG流程,都不可能从杂乱无章的数据中得到有价值的结果。2.改进提示方式在知识库缺乏信息,系统可能给出错误答案的情况下,改进提示方式可以起到显著帮助。例如,通过设置提示“如果你无法确定答案,请表明你不知道”可以鼓励模型认识到自己的局限并更透明地表达不确定性。虽然无法保证百分百准确,但在优化数据源之后,改进提示方式是我们能做的最好努力之一。问题二:错过排名靠前的文档2.1介绍一下错过排名靠前的文档问题?有时候系统在检索资料时,最关键的文件可能并没有出现在返回结果的最前面。这就导致了正确答案被忽略,系统因此无法给出精准的回答。即:“问题的答案其实在某个文档里面,只是它没有获得足够高的排名以致于没能呈现给用户”2.2如何解决错过排名靠前的文档问题?在将检索到的结果发送给大型语言模型(LLM)之前,对结果进行重新排名可以显著提升RAG的性能。LlamaIndex的一个笔记本展示了两种不同方法的效果对比:1.优化数据源1.重新排名检索结果2.调整数据块大小(chunk_size)和相似度排名(similarity_top_k)超参数chunk_size和similarity_top_k都是用来调控RAG(检索增强型生成)模型数据检索过程中效率和效果的参数。改动这些参数能够影响计算效率与信息检索质量之间的平衡。以LlamaIndex为例,下面是一个示例代码片段。定义函数objective_function_semantic_similarity,param_dict包含了参数chunk_size和top_k以及它们推荐的值:•直接检索前两个节点,不进行重新排名,这可能导致不准确的检索结果。•先检索前十个节点,然后使用CohereRerank进行重新排名,最后返回前两个节点,这种方法可以提高检索的准确性。param_tuner=ParamTuner(param_fn=objective_function_semantic_similarity,param_dict=param_dict,fi...

发表评论取消回复