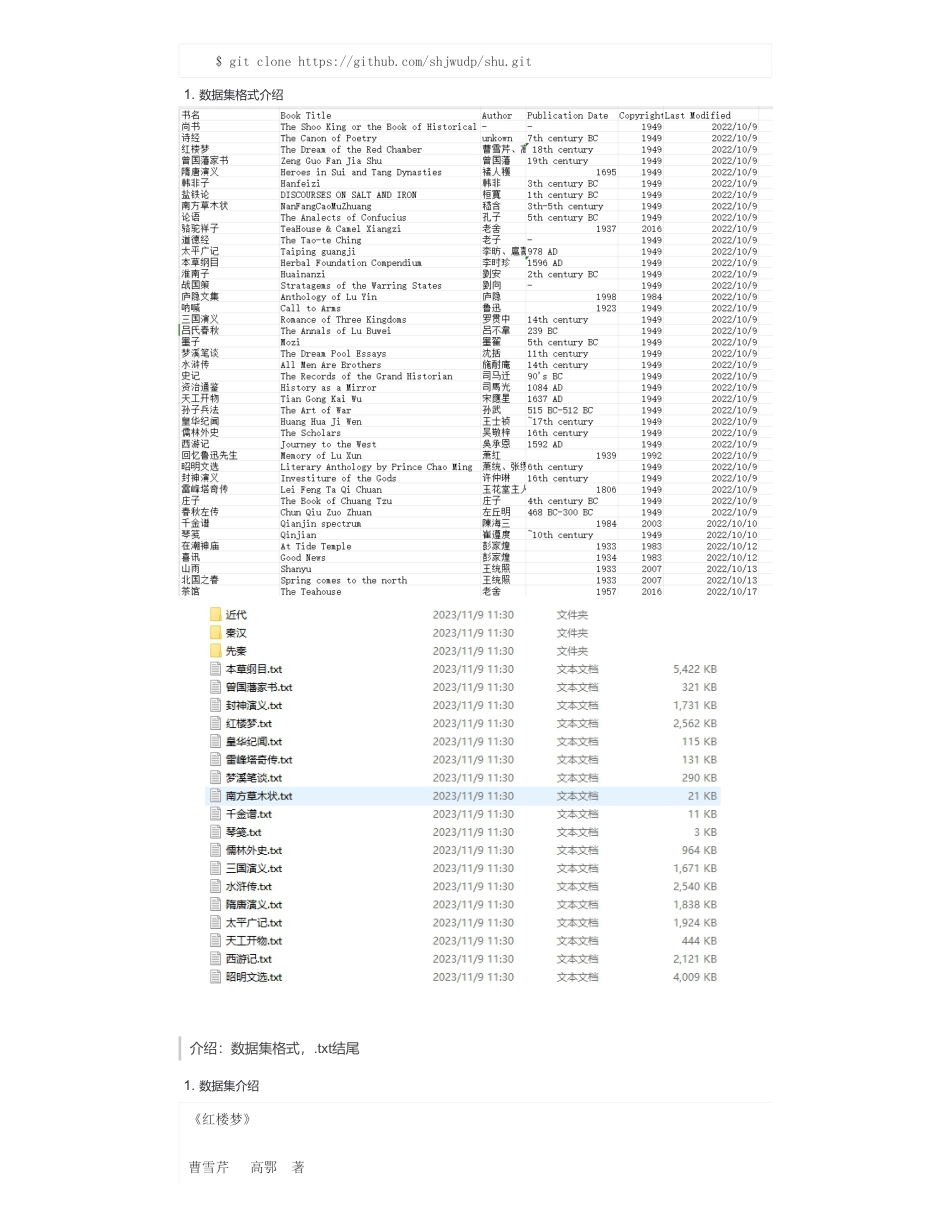

基于lora的llama2二次预训练来自:AiGC面试宝典宁静致远2024年01月27日20:47一、为什么需要对llama2做基于lora的二次预训练?加入中文训练语料进行llama2的二次预训练,这样模型就可以增加支持中文输出的能力。二、基于lora的llama2二次预训练的目标是什么?在保持预训练模型权重不变的情况下,通过添加额外的网络层并仅训练这些新增的网络层参数,实现大模型的高效微调(peft)。三、基于lora的llama2二次预训练的思想是什么?思想:基于对模型本征维度(intrinsicdimension)的理解。“本征维度”是指模型中真正有用的、能够影响模型输出的参数数量。Aghajanyan研究发现,预训练模型的内在维度实际上非常小,即只有一小部分参数对模型输出有显著影响。就是存在一个极低维度的参数,微调它和在全参数空间中微调能起到相同的效果LORA假设模型在任务适配过程中权重的改变量是低秩(lowrank)W=W0+ΔW,ΔW=BA参数更新范围:只训练新增的网络层参数四、基于lora的llama2二次预训练语料构建思路?本项目基于lora的llama2二次预训练语料来自中文书籍,一个中文书籍收录整理项目。•基于lora的llama2二次预训练•一、为什么需要对llama2做基于lora的二次预训练?•二、基于lora的llama2二次预训练的目标是什么?•三、基于lora的llama2二次预训练的思想是什么?•四、基于lora的llama2二次预训练语料构建思路?•五、如何基于lora的llama2二次预训练?•5.1基于lora的llama2二次预训练参数介绍•5.2基于lora的llama2二次预训练•六、如何基于lora的llama2微调?•6.1训练数据介绍•6.2基于lora的llama2微调参数介绍•6.3基于lora的llama2微调•七、如何使用基于lora的llama2做推理?•致谢1.预训练数据集下载扫码加查看更多介绍:数据集格式,.txt结尾$gitclonehttps://github.com/shjwudp/shu.git1.数据集格式介绍1.数据集介绍《红楼梦》曹雪芹高鄂著第一回甄士隐梦幻识通灵贾雨村风尘怀闺秀列位看官:你道此书从何而来?说起根由,虽近荒唐,细按则深有趣味。待在下将此来历注明,方使阅者了然不惑。原来女娲氏炼石补天之时,于大荒山无稽崖炼成高经十二丈、方经二十四丈顽石三万六千五百零一块。娲皇氏只用了三万六千五百块,只单单剩了一块未用,便弃在此山青埂峰下。谁知此石自经煅炼之后,灵性已通,因见众石俱得补天,独自己无材不堪入选,遂自怨自叹,日夜悲号惭愧。一日,正当嗟悼之际,俄见一僧一道远远而来,生得骨格不凡,丰神迥别,说说笑笑,来至峰下,坐于石边,高谈快论:先是说些云山雾海、神仙玄幻之事,后便说到红尘中荣华富贵。此石听了,不觉打动凡心,也想要到人间去享一享这荣华富贵,但自恨粗蠢,不得已,便口吐人言,向那僧道说道:“大师,弟子蠢物,不能见礼了!适闻二位谈那人世间荣耀繁华,心切慕之。弟子质虽粗蠢,性却稍通,况见二师仙形道体,定非凡品,必有补天济世之材,利物济人之德。如蒙发一点慈心,携带弟子得入红尘,在那富贵场中,温柔乡里受享几年,自当永佩洪恩,万劫不忘也!”二仙师听毕,齐憨笑道:“善哉,善哉!那红尘中有却有些乐事,但不能永远依恃;况又有‘美中不足,好事多磨’八个字紧相连属,瞬息间则又乐极悲生,人非物换,究竟是到头一梦,万境归空,倒不如不去的好。”这石凡心已炽,那里听得进这话去,乃复苦求再四。二仙知不可强制,乃叹道:“此亦静极思动,无中生有之数也!既如此,我们便携你去受享受享,只是到不得意时,切莫后悔!”石道:“自然,自然。”那僧又道:“若说你性灵,却又如此质蠢,并更无奇贵之处。如此也只好踮脚而已。也罢!我如今大施佛法,助你助,待劫终之日,复还本质,以了此案。你道好否?”石头听了,感谢不尽。那僧便念咒书符,大展幻术,将一块大石登时变成一块鲜明莹洁的美玉,且又缩成扇坠大小的可佩可拿。那僧托于掌上,笑道:“形体倒也是个宝物了!还只没有实在的好处,须得再镌上数字,使人一见便知是奇物方妙。然后好携你到那昌明隆盛之邦、诗礼簪缨之族、花柳繁华地、温柔富贵乡去安身乐业。”石头听了,喜不能禁,乃问:“不知赐了弟子那哪几件奇处?又不知携了弟子到何地方?望乞明...

发表评论取消回复