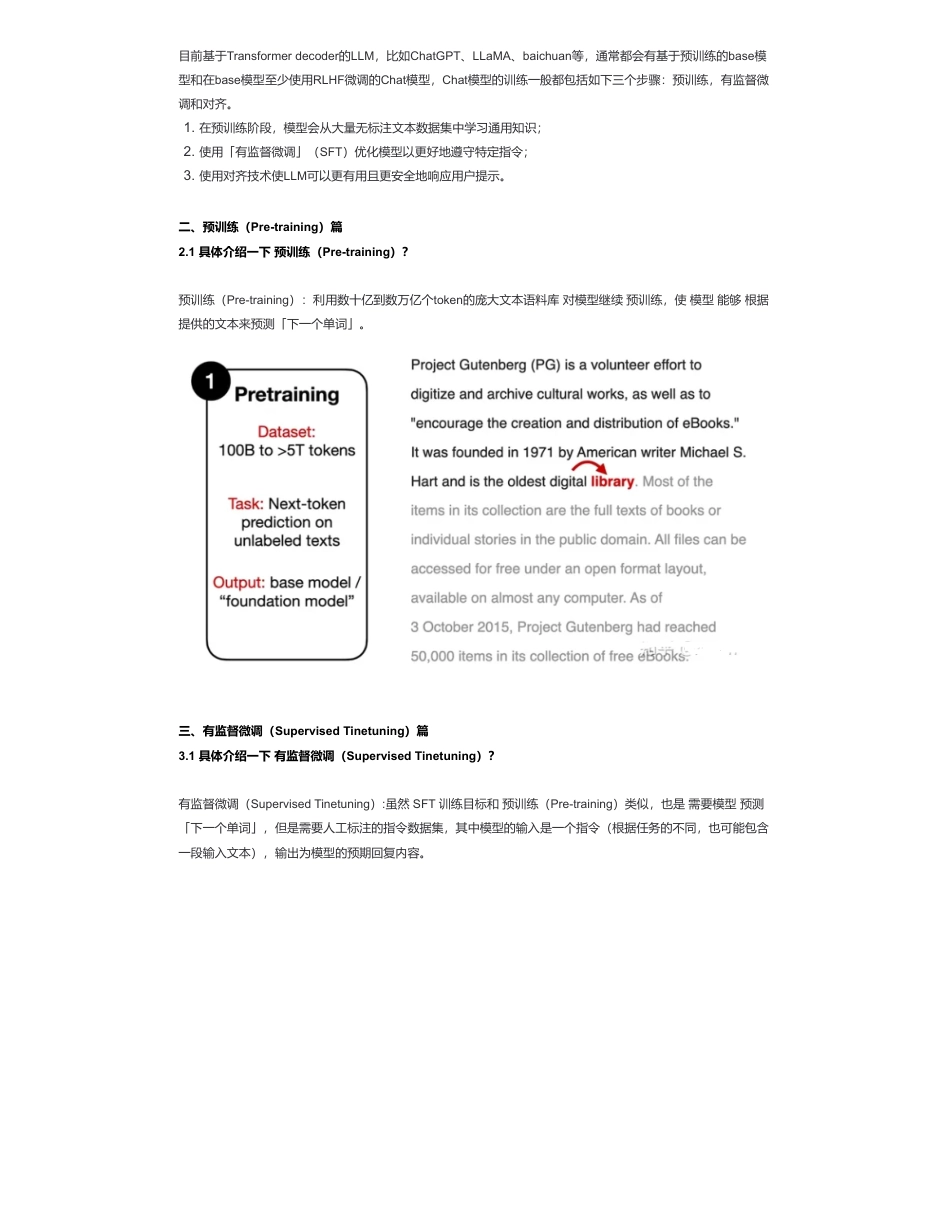

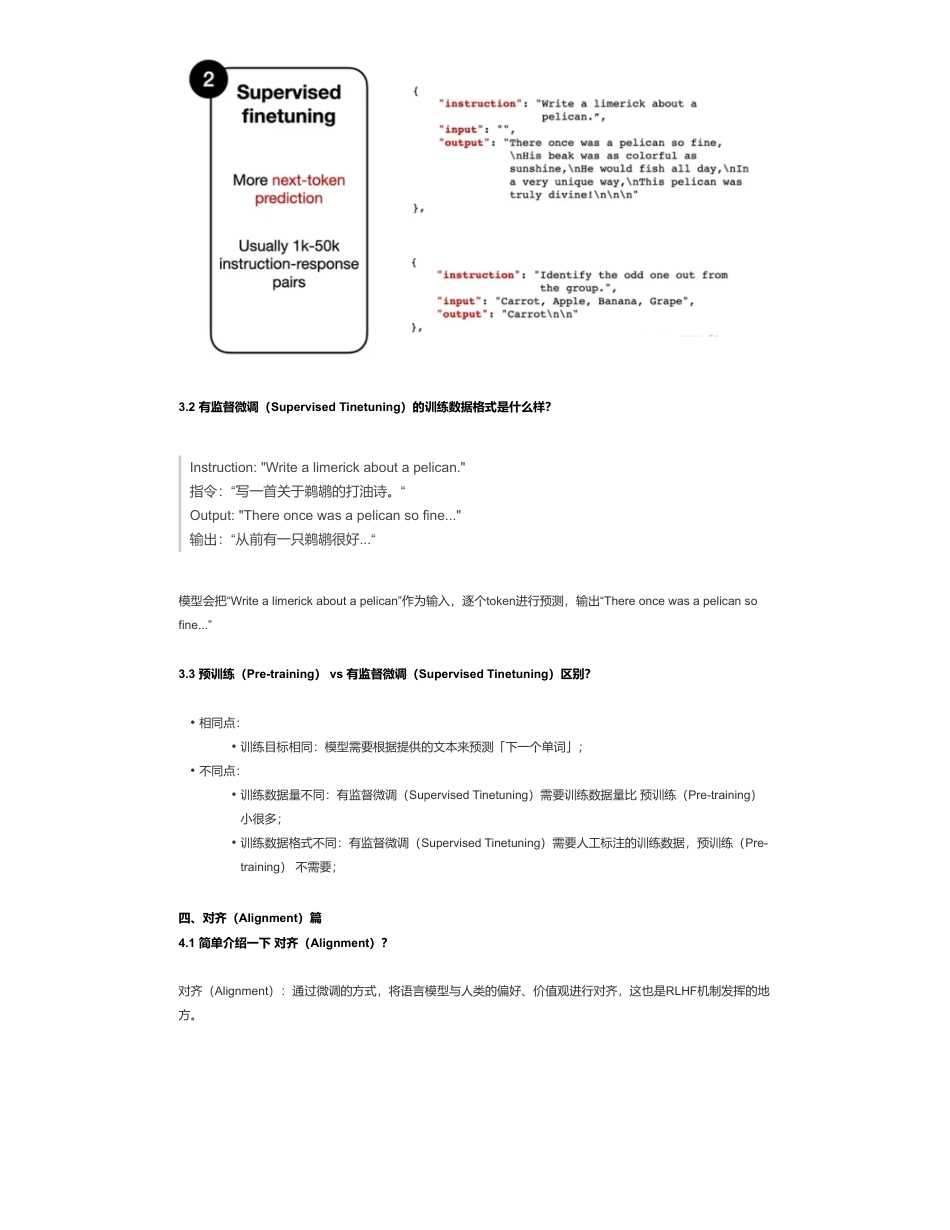

大模型(LLMs)强化学习——RLHF及其变种面来自:AiGC面试宝典宁静致远2024年01月27日20:47一、介绍一下LLM的经典预训练Pipeline?•大模型(LLMs)强化学习——RLHF及其变种面•一、介绍一下LLM的经典预训练Pipeline?•二、预训练(Pre-training)篇•2.1具体介绍一下预训练(Pre-training)?•三、有监督微调(SupervisedTinetuning)篇•3.1具体介绍一下有监督微调(SupervisedTinetuning)?•3.2有监督微调(SupervisedTinetuning)的训练数据格式是什么样?•3.3预训练(Pre-training)vs有监督微调(SupervisedTinetuning)区别?•四、对齐(Alignment)篇•4.1简单介绍一下对齐(Alignment)?•五、ReinforcementLearningwithHumanFeedback(RLHF)篇•5.1简单介绍一下RLHF流程?•5.2如何在在预训练好的模型上进行有监督微调?•5.3如何在有监督微调模型基础上创建一个RM模型?•5.4如何基于RM模型使用PPO算法微调SFT模型?•5.5instructGPT的原理,讲讲rlhf和reward?•六、LLaMA2的RLHF篇•6.1介绍一下LLaMA2的RLHF?•6.2LLaMA2中MarginLoss的实现逻辑?•6.3LLaMA2中两个RM模型的实现逻辑?•6.4LLaMA2中拒绝采样逻辑?•七、RLHF替代方案篇•7.1为什么需要RLHF替代方案?•7.2RLHF有哪些替代方案?•替代方案1:ConstitutionalAI:HarmlessnessfromAIFeedback•替代方案2:TheWisdomofHindsightMakesLanguageModelsBetterInstructionFollowers•替代方案3:DirectPreferenceOptimization:YourLanguageModelisSecretlyaRewardModel•替代方案4:ReinforcedSelf-Training(ReST)forLanguageModeling•替代方案5:RLAIF:ScalingReinforcementLearningfromHumanFeedbackwithAIFeedback•八、RLHF实践篇•8.1RLHF训练过程,怎么选取最优checkpoint?•参考扫码加查看更多目前基于Transformerdecoder的LLM,比如ChatGPT、LLaMA、baichuan等,通常都会有基于预训练的base模型和在base模型至少使用RLHF微调的Chat模型,Chat模型的训练一般都包括如下三个步骤:预训练,有监督微调和对齐。二、预训练(Pre-training)篇2.1具体介绍一下预训练(Pre-training)?预训练(Pre-training):利用数十亿到数万亿个token的庞大文本语料库对模型继续预训练,使模型能够根据提供的文本来预测「下一个单词」。三、有监督微调(SupervisedTinetuning)篇3.1具体介绍一下有监督微调(SupervisedTinetuning)?有监督微调(SupervisedTinetuning):虽然SFT训练目标和预训练(Pre-training)类似,也是需要模型预测「下一个单词」,但是需要人工标注的指令数据集,其中模型的输入是一个指令(根据任务的不同,也可能包含一段输入文本),输出为模型的预期回复内容。1.在预训练阶段,模型会从大量无标注文本数据集中学习通用知识;2.使用「有监督微调」(SFT)优化模型以更好地遵守特定指令;3.使用对齐技术使LLM可以更有用且更安全地响应用户提示。3.2有监督微调(SupervisedTinetuning)的训练数据格式是什么样?Instruction:"Writealimerickaboutapelican."指令:“写一首关于鹈鹕的打油诗。“Output:"Thereoncewasapelicansofine..."输出:“从前有一只鹈鹕很好...“模型会把“Writealimerickaboutapelican”作为输入,逐个token进行预测,输出“Thereoncewasapelicansofine...”3.3预训练(Pre-training)vs有监督微调(SupervisedTinetuning)区别?四、对齐(Alignment)篇4.1简单介绍一下对齐(Alignment)?对齐(Alignment):通过微调的方式,将语言模型与人类的偏好、价值观进行对齐,这也是RLHF机制发挥的地方。•相同点:•训练目标相同:模型需要根据提供的文本来预测「下一个单词」;•不同点:•训练数据量不同:有监督微调(SupervisedTinetuning)需要训练数据量比预训练(Pre-training)小很多;•训练数据格式不同:有监督微调(SupervisedTinetuning)需要人工标注的训练数据,预训练(Pre-training)不需要;五、ReinforcementLearningwithHumanFeedback(RLHF)篇5.1简单介绍一下RLHF流程?5.2如何在在预训练好的模型上进行有监督微调?先收集一个Prompts集合,并要求...

发表评论取消回复