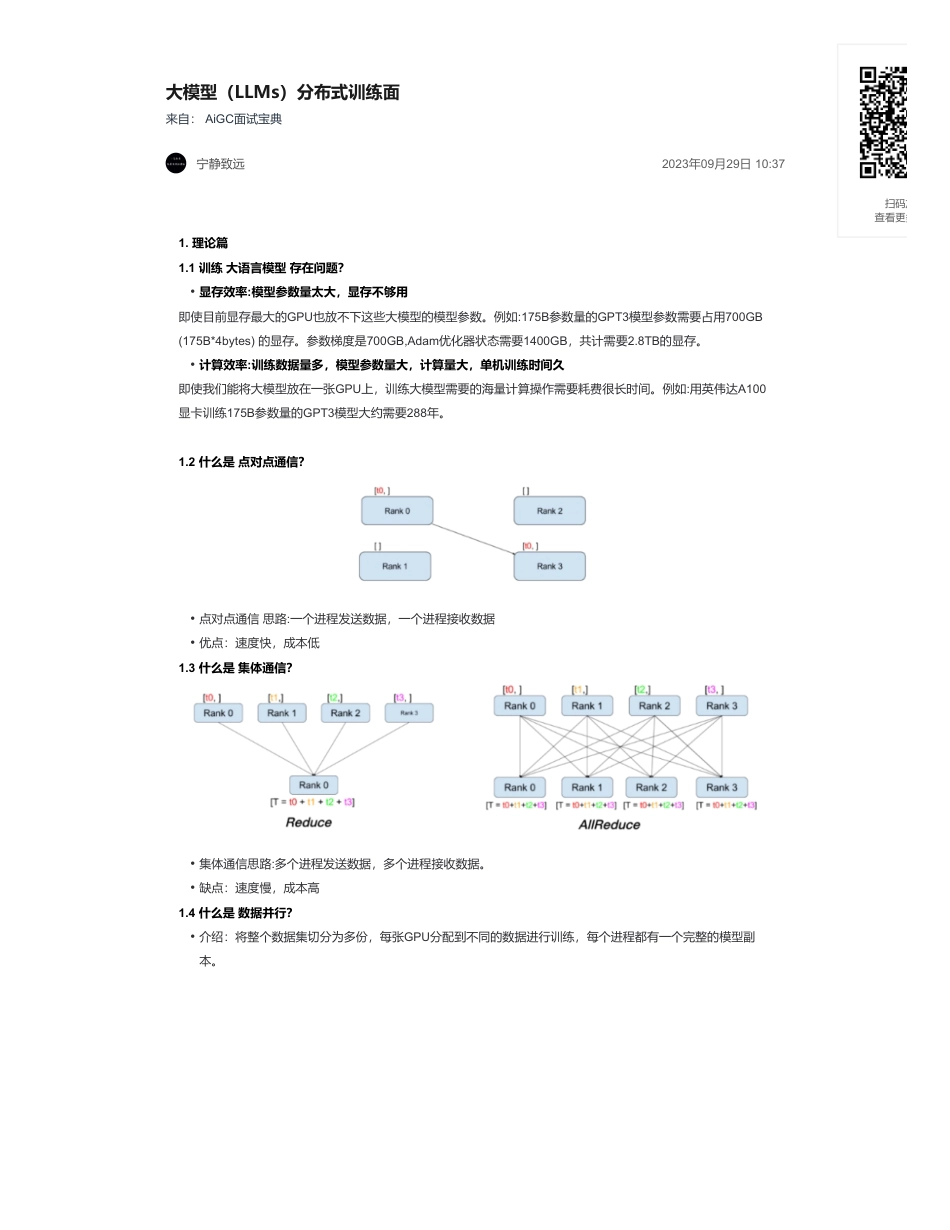

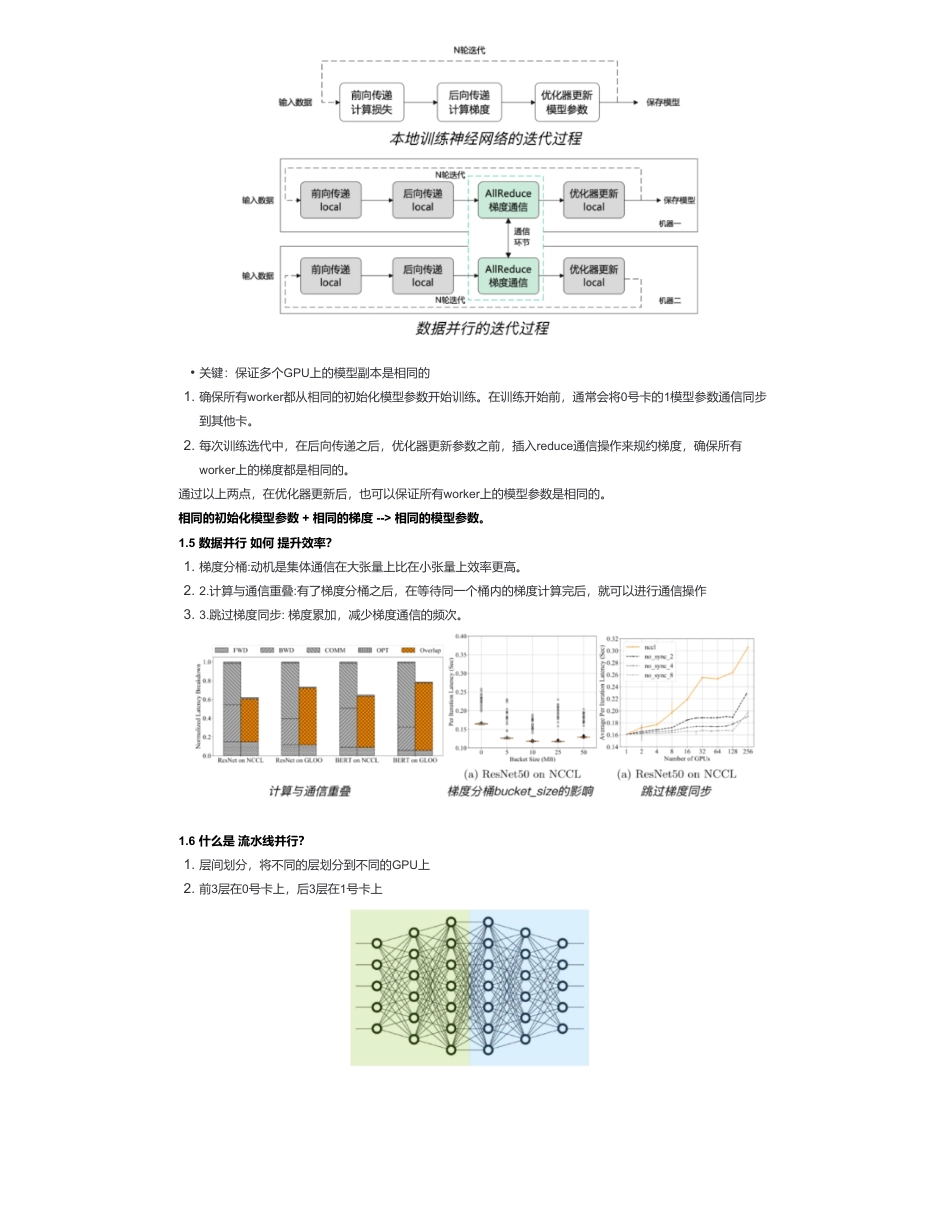

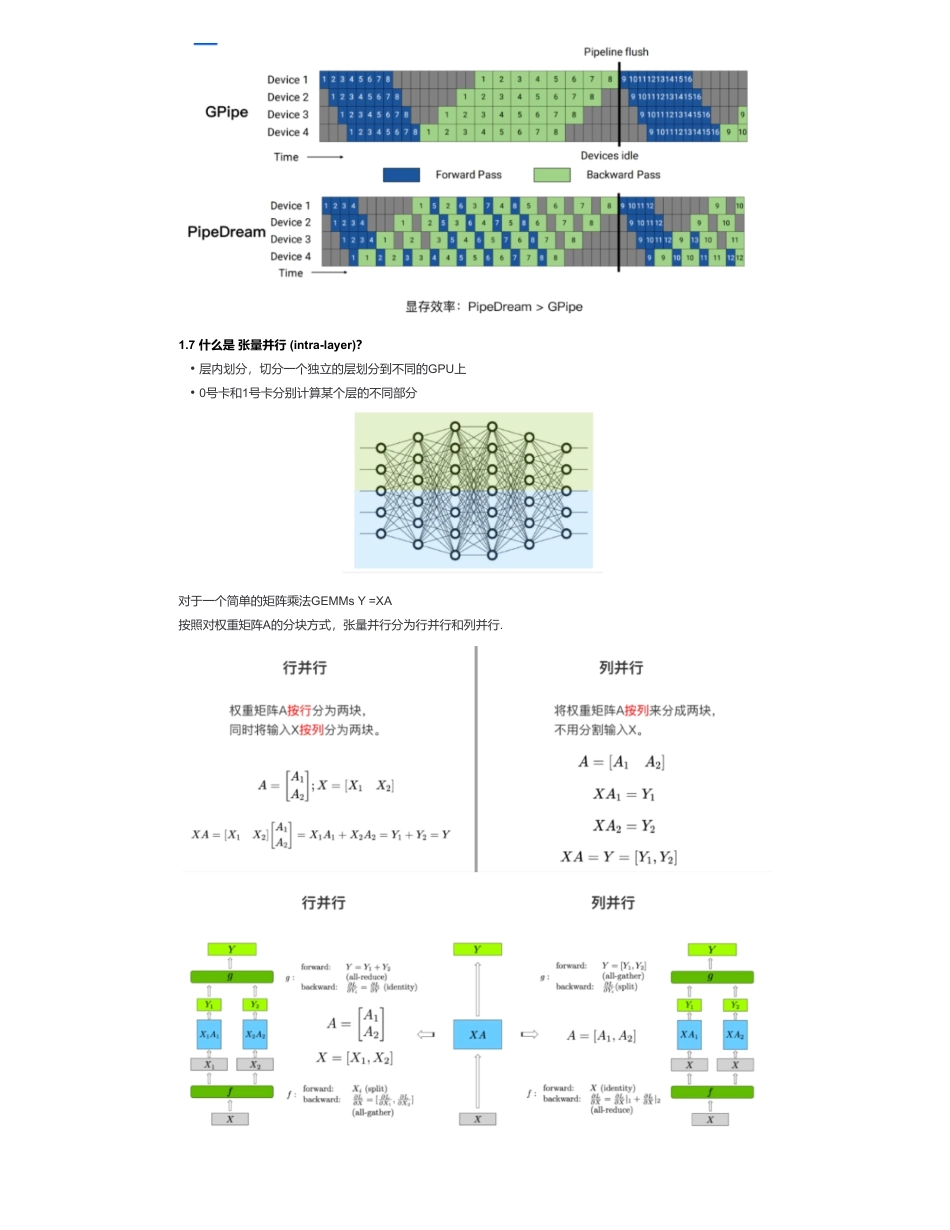

大模型(LLMs)分布式训练面来自:AiGC面试宝典宁静致远2023年09月29日10:371.理论篇1.1训练大语言模型存在问题?即使目前显存最大的GPU也放不下这些大模型的模型参数。例如:175B参数量的GPT3模型参数需要占用700GB(175B*4bytes)的显存。参数梯度是700GB,Adam优化器状态需要1400GB,共计需要2.8TB的显存。即使我们能将大模型放在一张GPU上,训练大模型需要的海量计算操作需要耗费很长时间。例如:用英伟达A100显卡训练175B参数量的GPT3模型大约需要288年。1.2什么是点对点通信?1.3什么是集体通信?1.4什么是数据并行?•显存效率:模型参数量太大,显存不够用•计算效率:训练数据量多,模型参数量大,计算量大,单机训练时间久•点对点通信思路:一个进程发送数据,一个进程接收数据•优点:速度快,成本低•集体通信思路:多个进程发送数据,多个进程接收数据。•缺点:速度慢,成本高•介绍:将整个数据集切分为多份,每张GPU分配到不同的数据进行训练,每个进程都有一个完整的模型副本。扫码加查看更多通过以上两点,在优化器更新后,也可以保证所有worker上的模型参数是相同的。相同的初始化模型参数+相同的梯度-->相同的模型参数。1.5数据并行如何提升效率?1.6什么是流水线并行?•关键:保证多个GPU上的模型副本是相同的1.确保所有worker都从相同的初始化模型参数开始训练。在训练开始前,通常会将0号卡的1模型参数通信同步到其他卡。2.每次训练选代中,在后向传递之后,优化器更新参数之前,插入reduce通信操作来规约梯度,确保所有worker上的梯度都是相同的。1.梯度分桶:动机是集体通信在大张量上比在小张量上效率更高。2.2.计算与通信重叠:有了梯度分桶之后,在等待同一个桶内的梯度计算完后,就可以进行通信操作3.3.跳过梯度同步:梯度累加,减少梯度通信的频次。1.层间划分,将不同的层划分到不同的GPU上2.前3层在0号卡上,后3层在1号卡上1.7什么是张量并行(intra-layer)?对于一个简单的矩阵乘法GEMMsY=XA按照对权重矩阵A的分块方式,张量并行分为行并行和列并行.•层内划分,切分一个独立的层划分到不同的GPU上•0号卡和1号卡分别计算某个层的不同部分1.8数据并行vs张量并行vs流水线并行?显存效率:模型并行>流水线并行>数据并行通信效率:流水线并行>数据并行>模型并行1.9什么是3D并行?3D并行。4路张量并行,4路流水线并行,2路数据并行。共32个workers。1.10想要训练1个LLM,如果只想用1张显卡,那么对显卡的要求是什么?显卡显存足够大,nB模型微调一般最好准备20nGB以上的显存。1.11如果有N张显存足够大的显卡,怎么加速训练?数据并行(DP),充分利用多张显卡的算力。1.12如果显卡的显存不够装下一个完整的模型呢?最直观想法,需要分层加载,把不同的层加载到不同的GPU上(accelerate的device_map)也就是常见的PP,流水线并行。1.13PP推理时,是一个串行的过程,1个GPU计算,其他空闲,有没有其他方式?1.143种并行方式可以叠加吗?是可以的,DP+TP+PP,这就是3D并行。如果真有1个超大模型需要预训练,3D并行那是必不可少的。毕竟显卡进化的比较慢,最大显存的也就是A10080g。单卡80g,可以完整加载小于40B的模型,但是训练时+梯度+优化器状态,5B模型就是上限了,更别说activation的参数也要占显存,batchsize还得大。而现在100亿以下(10B以下)的LLM只能叫smallLLM。1.15Colossal-AI有1D/2D/2.5D/3D,是什么情况?Colossal-AI的nD是针对张量并行,指的是TP的切分,对于矩阵各种切,和3D并行不是一回事。1.16除了3D并行有没有其他方式大规模训练?•数据并行:计算效率高、实现简单。•显存效率:每张卡上都保存了完整的模型、梯度、优化器状态,因此显存效率不高•计算效率:当增加并行度时,单卡的计算量是保持恒定的,可以实现近乎完美的线性扩展。但规约梯度的通信开销,与模型大小成正相关。•张量并行:因模型结构而异,实现难度大。•显存效率:随着并行度增加,成比例地减少显存占用。是减少单层神经网络中间激活的唯一方法•计算效率:频繁的通信,限制了两个通信阶段之间的计算量,影响了计算效率,计算效率很低。•流水线并行:通信成本最低•显存效率:减少...

发表评论取消回复